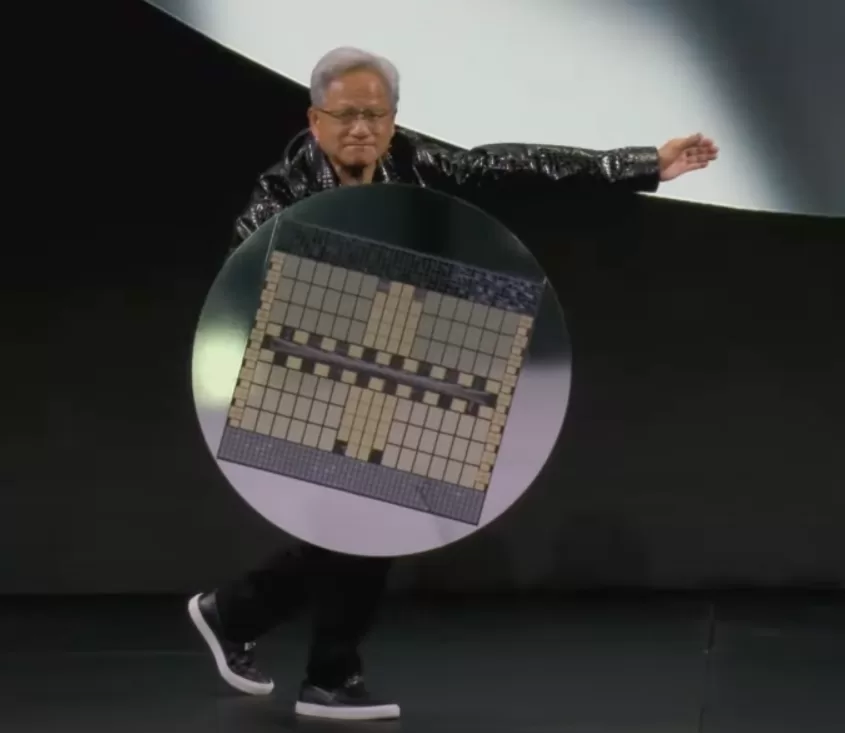

Nvidia: Jensen Huang (CEO da empresa), diz que o desempenho dos chips de IA de sua empresa está avançando mais rápido do que a Lei de Moore previu

“Nossos sistemas estão progredindo muito mais rápido do que a Lei de Moore”, disse Huang em entrevista ao site TechCrunch na CES em Las Vegas.

A Lei de Moore, formulada em 1965 por Gordon Moore, cofundador da Intel, prevê que o número de transistores em um chip de computador dobra aproximadamente a cada dois anos, enquanto os custos de produção se mantêm estáveis.

Essa observação impulsionou o avanço exponencial da tecnologia, permitindo dispositivos menores, mais rápidos e acessíveis.

Embora tenha sido válida por décadas, a Lei de Moore está desacelerando devido a limites físicos dos semicondutores. Para contornar isso, novas tecnologias como chips 3D, computação quântica e inteligência artificial estão emergindo.

Essa transição marca um novo capítulo na evolução tecnológica, reafirmando o papel da inovação no futuro da computação.

Essa previsão deu certo e criou avanços rápidos na capacidade e custos em queda por décadas.

Nos últimos anos, a Lei de Moore desacelerou

No entanto, Huang afirma que os chips de IA da Nvidia estão se movendo em um ritmo acelerado próprio; a empresa diz que seu mais recente superchip de data center é mais de 30 vezes mais rápido para executar cargas de trabalho de inferência de IA do que sua geração anterior.

“Podemos construir a arquitetura, o chip, o sistema, as bibliotecas e os algoritmos, tudo ao mesmo tempo”, disse Huang. “Se você fizer isso, poderá se mover mais rápido do que a Lei de Moore, porque pode inovar em toda a pilha.”

A afirmação ousada do CEO da Nvidia vem em um momento em que muitos estão questionando se o progresso da IA estagnou.

Os principais laboratórios de IA – como Google, OpenAI e Anthropic – usam os chips de IA da Nvidia para treinar e executar seus modelos de IA, e os avanços nesses chips provavelmente se traduziriam em mais progresso nos recursos do modelo de IA.

Esta não é a primeira vez que Huang sugere que a Nvidia está superando a Lei de Moore.

Em um podcast em novembro, Huang sugeriu que o mundo da IA está no ritmo da “hiper Lei de Moore”.

Huang rejeita a ideia de que o progresso da IA está diminuindo

Em vez disso, ele afirma que agora existem três leis ativas de dimensionamento de IA: pré-treinamento, a fase inicial de treinamento em que os modelos de IA aprendem padrões a partir de grandes quantidades de dados; pós-treinamento, que ajusta as respostas de um modelo de IA usando métodos como feedback humano; e computação em tempo de teste, que ocorre durante a fase de inferência e dá a um modelo de IA mais tempo para “pensar” após cada pergunta.

“A Lei de Moore foi tão importante na história da computação porque reduziu os custos de computação”, disse Huang ao TechCrunch. “A mesma coisa vai acontecer com a inferência, onde aumentamos o desempenho e, como resultado, o custo da inferência será menor.”

Os H100s da Nvidia foram o chip preferido das empresas de tecnologia que buscam treinar modelos de IA, mas agora que as empresas de tecnologia estão se concentrando mais na inferência, alguns questionaram se os chips caros da Nvidia ainda permanecerão no topo.

Os modelos de IA que usam computação em tempo de teste são caros para executar hoje. Existe a preocupação de que o modelo o3 da OpenAI, que usa uma versão ampliada da computação em tempo de teste, seja muito caro para a maioria das pessoas usar. Por exemplo, a OpenAI gastou quase US$ 20 por tarefa usando o o3 para obter pontuações de nível humano em um teste de inteligência geral. Uma assinatura do ChatGPT Plus custa US$ 20 por um mês inteiro de uso. Rsssss

Huang ergueu o mais recente superchip de data center da Nvidia, o GB200 NVL72, no palco como um escudo durante a palestra de segunda-feira. Este chip é 30 a 40x mais rápido na execução de cargas de trabalho de inferência de IA do que os chips mais vendidos anteriores da Nvidia, o H100.

Huang diz que esse salto de desempenho significa que modelos de raciocínio de IA como o o3 da OpenAI, que usa uma quantidade significativa de computação durante a fase de inferência, se tornarão mais baratos com o tempo.

Huang diz que, em geral, está focado na criação de chips de melhor desempenho e que chips de melhor desempenho criam preços mais baixos a longo prazo.

“A solução direta e imediata para computação em tempo de teste, tanto em desempenho quanto em custo, é aumentar nossa capacidade de computação”, disse Huang ao TechCrunch.

Ele observou que, a longo prazo, os modelos de raciocínio de IA podem ser usados para criar melhores dados para o pré-treinamento e pós-treinamento de modelos de IA.

Certamente vimos o preço dos modelos de IA despencar no ano passado, em parte devido aos avanços da computação de empresas de hardware como a Nvidia.

Huang diz que essa é uma tendência que ele espera continuar com os modelos de raciocínio de IA, embora as primeiras versões que vimos da OpenAI tenham sido bastante caras.

De forma mais ampla, Huang afirmou que seus chips de IA hoje são 1.000 vezes melhores do que há 10 anos. Esse é um ritmo muito mais rápido do que o padrão estabelecido pela Lei de Moore, que Huang diz que não vê sinais de parar em breve.