História da Inteligência Artificial: De Turing ao GPT

A inseparável história da Inteligência Artificial e da Informática

A história da Inteligência Artificial (IA) e da Informática está intrinsecamente ligada, com raízes que remontam ao desenvolvimento inicial dos computadores.

Desde os primeiros passos da computação na década de 1940, como os conceitos de Alan Turing, até as inovações atuais, a evolução da IA reflete o avanço tecnológico que moldou o campo da Informática.

No início, os cientistas buscavam entender se as máquinas poderiam “pensar”, um questionamento que levou à criação de sistemas que simulam processos humanos.

Com o surgimento de redes neurais e machine learning, a IA e a Informática tornaram-se aliadas inseparáveis, trazendo inovações que transformaram setores inteiros.

Conheça como essa parceria histórica continua moldando o futuro da tecnologia e a nossa interação com as máquinas.

Tornando a IA Possível

No início do século XX, a ficção científica introduziu o conceito de robôs com inteligência artificial ao mundo.

Tudo começou com o Homem de Lata “sem coração” de O Mágico de Oz e prosseguiu com o robô humanoide que representava Maria em Metrópolis.

Já na década de 1950, uma geração de cientistas, matemáticos e filósofos tinha o conceito de inteligência artificial (IA) firmemente estabelecido em suas mentes.

Um deles era Alan Turing, um jovem polímata britânico que investigou a possibilidade matemática da inteligência artificial.

Turing propôs que, assim como os humanos utilizam as informações disponíveis e a razão para resolver problemas e fazer escolhas, as máquinas também poderiam fazer o mesmo.

Essa foi a premissa central de seu artigo de 1950, “Computing Machinery and Intelligence“, onde ele abordou como criar máquinas inteligentes e como avaliar sua inteligência.

Infelizmente, falar é fácil.

Os obstáculos de Turing

Inicialmente, era essencial uma mudança fundamental nos computadores.

Antes de 1949, eles não possuíam um pré-requisito crucial para a inteligência: a capacidade de armazenar comandos, podendo apenas executá-los.

Ou seja, os computadores podiam receber instruções sobre o que fazer, mas não tinham a capacidade de reter informações sobre suas ações.

Além disso, a computação era extremamente custosa. No começo dos anos 1950, alugar um computador podia custar até US$ 200.000 ao mês. Somente universidades renomadas e grandes corporações tecnológicas podiam se permitir explorar esse território inexplorado.

Era necessário uma prova de conceito e o apoio de figuras proeminentes para convencer os financiadores do potencial da inteligência artificial.

A conferência que marcou o começo de tudo

Cinco anos após sua concepção, o Logic Theorist, criado por Allen Newell, Cliff Shaw e Herbert Simon, foi iniciado como uma prova de conceito.

Este programa, financiado pela RAND Corporation, foi desenhado para replicar a capacidade humana de resolver problemas e é amplamente reconhecido como o primeiro software de inteligência artificial.

Sua apresentação ocorreu durante o Dartmouth Summer Research Project on Artificial Intelligence (DSRPAI) em 1956, um evento histórico organizado por John McCarthy e Marvin Minsky. McCarthy, vislumbrando uma colaboração massiva, convocou renomados pesquisadores de diversas áreas para um debate aberto sobre a inteligência artificial, termo que ele mesmo introduziu na conferência.

A despeito das altas expectativas de McCarthy, a conferência não atingiu seu objetivo principal: não houve consenso sobre metodologias padrão para a área e os participantes não se engajaram como esperado.

Contudo, houve uma unânime e entusiástica concordância sobre a viabilidade da IA.

O legado da conferência é indiscutível, pois ela impulsionou duas décadas subsequentes de investigações no campo da inteligência artificial.

Os altos e baixos

De 1957 a 1974, a IA floresceu.

Os computadores podiam armazenar mais informações e se tornaram mais rápidos, baratos e acessíveis.

Os algoritmos de aprendizado de máquina também melhoraram e as pessoas ficaram melhores em saber qual algoritmo aplicar ao seu problema.

As primeiras demonstrações, como o General Problem Solver de Newell e Simon e o ELIZA de Joseph Weizenbaum, mostraram-se promissoras em relação aos objetivos de resolução de problemas e interpretação da linguagem falada, respectivamente.

Esses êxitos, assim como o apoio de pesquisadores renomados (isto é, os integrantes do DSRPAI), persuadiram órgãos governamentais, como a Defense Advanced Research Projects Agency (DARPA), a investir em pesquisas de inteligência artificial em diversas instituições.

O governo mostrava grande interesse em desenvolver uma máquina capaz de transcrever e traduzir a linguagem falada, além de processar grandes volumes de dados com eficiência.

O otimismo era contagiante e as expectativas, elevadas. Em 1970, Marvin Minsky declarou à revista Life: ‘em três a oito anos, teremos uma máquina com a inteligência geral de um ser humano médio’.

Apesar de avanços significativos, ainda havia muito a ser feito para alcançar os objetivos ambiciosos de processamento de linguagem natural, pensamento abstrato e autorreconhecimento.

A jornada estava apenas começando.

Desvendar o potencial da IA trouxe à tona uma série de obstáculos significativos.

O maior desafio da IA?

A insuficiência de poder computacional para realizar operações complexas: os computadores da época não tinham capacidade de armazenar grandes volumes de dados nem processá-los rapidamente.

Para simular a comunicação humana, por exemplo, seria necessário compreender o significado de um vasto vocabulário em incontáveis combinações.

Hans Moravec, então doutorando de John McCarthy, afirmou que ‘os computadores eram ainda milhões de vezes fracos demais para exibir inteligência’.

Com o tempo, a paciência e o financiamento escassearam, desacelerando o avanço da pesquisa por uma década.

Nos anos 1980, a IA ganhou novo impulso por duas forças principais: o surgimento de novas ferramentas algorítmicas e o aumento significativo de investimentos.

John Hopfield e David Rumelhart popularizaram a ‘aprendizagem profunda’, permitindo que computadores aprendessem com base em experiência.

Simultaneamente, Edward Feigenbaum introduziu sistemas especialistas, que imitavam o processo de decisão de um especialista humano, tornando possível que não especialistas recebessem conselhos precisos do sistema.

Esses sistemas rapidamente ganharam espaço na indústria.

O Japão, com seu ambicioso Projeto de Computador de Quinta Geração (FGCP), investiu cerca de US$ 400 milhões de 1982 a 1990 para revolucionar o processamento de dados e a IA.

Embora não tenha atingido todas as metas, o FGCP inspirou uma nova geração de engenheiros e cientistas. Mesmo assim, com o fim dos financiamentos, a IA voltou a sair dos holofotes.

Ironia do destino, foi na ausência de financiamento estatal e divulgação pública que a inteligência artificial floresceu.

Nas décadas de 1990 e 2000, várias metas significativas da IA foram atingidas.

Em 1997, o campeão mundial de xadrez e grande mestre da época, Gary Kasparov, foi vencido pelo Deep Blue da IBM, um software de xadrez.

Essa partida amplamente publicitada marcou a primeira vez que um campeão mundial em título foi derrotado por um computador, representando um avanço para os programas de decisão baseados em IA.

No mesmo ano, o reconhecimento de voz desenvolvido pela Dragon Systems foi integrado ao Windows, marcando outro avanço, desta vez para a interpretação de linguagem falada.

As máquinas pareciam capazes de resolver qualquer problema, até mesmo compreender emoções humanas, como demonstrado pelo robô Kismet, criado por Cynthia Breazeal, que podia reconhecer e simular emoções.

O tempo resolve tudo… quase tão bem quanto a IA

Não aprimoramos a forma de codificar a inteligência artificial, então o que mudou?

O antigo limite de armazenamento e processamento dos computadores, que travava o avanço da IA há 30 anos, já não era mais um obstáculo.

A Lei de Moore — que prevê que a capacidade de memória e velocidade dos computadores dobra a cada ano — finalmente nos alcançou e, em muitos casos, até superou nossas necessidades. Foi assim que o Deep Blue derrotou Garry Kasparov em 1997 e, mais recentemente, o AlphaGo do Google venceu Ke Jie, campeão chinês de Go.

Esse avanço ilustra a montanha-russa da pesquisa em IA: expandimos as capacidades até o limite do nosso poder computacional e, então, aguardamos a próxima onda da Lei de Moore para novos avanços.

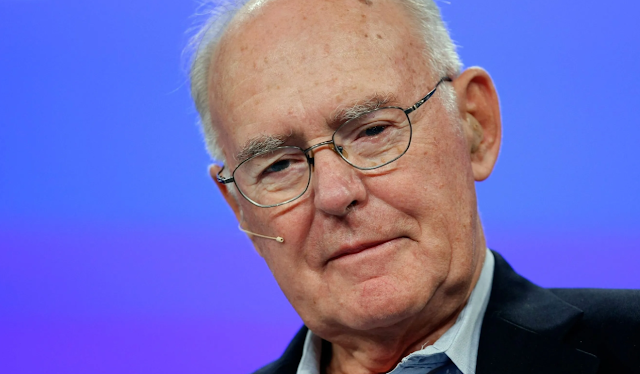

A Lei de Moore

A Lei de Moore é uma observação formulada pelo co-fundador da Intel, Gordon Moore, em 1965, que prevê o ritmo exponencial do avanço tecnológico em microchips.

Moore observou que o número de transistores em um circuito integrado dobraria aproximadamente a cada dois anos, resultando em um aumento exponencial na capacidade de processamento e eficiência dos computadores, com uma redução proporcional nos custos.

Essa projeção definiu o ritmo de desenvolvimento da indústria de semicondutores por décadas e impulsionou a inovação em áreas como computação, inteligência artificial, telecomunicações e eletrônicos de consumo.

A Lei de Moore se mostrou um catalisador essencial para avanços revolucionários, como a criação de dispositivos móveis, expansão de redes globais e surgimento da IA moderna.

Com o aumento contínuo na densidade de transistores, foi possível aprimorar a velocidade e a eficiência de processadores, tornando os computadores mais acessíveis e poderosos.

No entanto, à medida que a tecnologia de transistores se aproxima de seus limites físicos, os especialistas questionam a sustentabilidade da Lei de Moore.

Apesar dos desafios, alternativas como a computação quântica, a integração de novos materiais e a criação de processadores especializados em IA indicam que o espírito da Lei de Moore pode continuar impulsionando o desenvolvimento tecnológico.

Embora a Lei de Moore possa desacelerar, sua influência permanece viva, guiando a indústria de tecnologia em busca de inovações e soluções para superar os limites físicos atuais.

A inteligência artificial já está presente em todos os lugares

Atualmente, vivemos na era do “big data”, um período em que podemos coletar quantidades imensas de dados, muitos dos quais são complexos demais para serem processados por uma pessoa.

A inteligência artificial tem sido amplamente aplicada e gerado resultados significativos em diversos setores, incluindo tecnologia, finanças, marketing e entretenimento.

Observamos que, mesmo sem grandes avanços nos algoritmos, o big data e o processamento em larga escala possibilitam que a inteligência artificial se desenvolva através de aprendizado intensivo.

Embora existam indícios de que a Lei de Moore possa estar perdendo força, o crescimento exponencial dos dados não mostra sinais de desaceleração.

Progressos em áreas como ciência da computação, matemática e neurociência podem oferecer caminhos para superar as limitações impostas pela Lei de Moore.

O Futuro da IA

Então, o que está reservado para o futuro?

No futuro próximo, a linguagem de inteligência artificial “parece” ser a maior das inovações.

Na verdade, estas inovações já estão em pleno andamento.

Não me lembro da última vez que liguei para uma empresa e falei diretamente com um humano.

Hoje em dia, as máquinas estão até nos ligando! Alguém poderia imaginar, em 2024, interagir com um sistema especialista em uma conversa fluida, ou ter uma conversa em dois idiomas diferentes sendo traduzida em tempo real?

Também podemos esperar os carros autônomos dominando as estradas nos próximos vinte anos (e isso é uma previsão conservadora).

A meta a médio prazo é alcançar a inteligência geral artificial, isto é, uma máquina que exceda as capacidades cognitivas humanas em todas as tarefas.

Leia novamente: Em médio prazo.

Você está preparado? E seus filhos? Planejam se formar em quê? Trabalhar com quê?

Em no máximo em 50 a 100 anos teremos robôs sencientes, como os que vemos nos filmes.

Mesmo que a tecnologia esteja disponível, as questões éticas atuariam como um grande obstáculo à sua implementação.

Quando, ou melhor, antes que esse tempo chegue, será necessário ter um debate sério sobre a política e a ética das máquinas (ironicamente, temas profundamente humanos).

Por enquanto, no entanto, deixaremos que a IA continue a evoluir e a integrar-se na sociedade.

O que nos falta, hoje, é discussão sobre como iremos administrar isso.